A fotografia é a técnica que permite registrar o mundo, que é tridimensional, em apenas duas dimensões. Em outras palavras, a informação que vem do mundo contém largura, altura e profundidade, mas a que vai pra foto tem só largura e altura. Enquanto o mundo se estende pelo espaço, a fotografia se restringe a uma tela ou um pedaço de papel. Em termos matemáticos, pegamos objetos que têm coordenadas X, Y e Z e transformamos em imagens que possuem apenas coordenadas x e y.

O que de fato quer dizer ‘3D’

Aí reside a maior “desvantagem” da fotografia, que é a perda da informação. Cada dimensão do objeto cede um pouco do seu detalhe de modo que ele possa ser representado numa foto e ainda conserve uma aparência tridimensional. Não sei bem se essa questão de bi- ou tridimensional é clara ao leitor, mas é simples de entender. Uma laranja é um objeto aproximadamente esférico, se pegá-la na mão vai sentir o seu volume. Agora imagine que eu tirei uma foto dessa laranja, imprimi e coloquei na sua mão. O volume deixou de existir, a imagem se resume a uma folha. Mas note, também, que outra coisa se perde. Quando você movimenta a laranja na mão, pode vê-la por diversos ângulos. Já a foto, não. Isso é a informação tridimensional perdida que estou falando.

Porém, o que a gente chama de 3D em computação, hoje, nada mais é que um 2D dinâmico, afinal ainda representamos nossos objetos em telas bidimensionais. Por exemplo, uma laranja no computador tem volume somente no ambiente virtual do computador. No mundo real ela continua sendo uma imagem bidimensional porque a tela é bidimensional. Acontece que o computador é capaz de gerar representações bidimensionais de todos os ângulos possíveis, de modo que ele sempre tem uma imagem que representa as três dimensões do objeto. Mas, de todo modo, o resultado no mundo sempre é 2D.

Ou seja, o que nos prende no mundo 2D é a tela. É por isso que se investe tanto no desenvolvimento de realidade aumentada (ou realidade virtual), que nada mais é do que ambientes em que o usuário pode interagir verdadeiramente em três dimensões com os objetos virtuais. O problema é que o custo disso, ao contrário das tradicionais telas 2D, é que o usuário precisa ficar cognitivamente imerso no ambiente, o que o isola da realidade. Mas tudo isso é conversa pra um outro artigo, vamos voltar para a fotografia.

Fotogrametria

Já a fotografia sempre vai existir como a arte das duas dimensões. Afinal quadros, papel e telas devem existir, pelo menos, por um bom tempo ainda (a menos que o mundo realmente fique muito doido, o que tem se mostrado uma possibilidade assustadoramente real). Porém, a imagem estática é somente o resultado final do processo. As técnicas usadas para extrair informação do mundo tridimensional e transformá-la em bidimensional é que mudaram muito nos últimos 30 anos.

A questão de como preservar os aspectos tridimensionais do mundo utilizando a fotografia é tão antigo quanto a própria fotografia, e se chama fotogrametria. Utilizando fotografias de ângulos variados, se pode fazer medições, calcular perspectivas e reconstruir os objetos num ambiente virtual. No início, essa tecnologia era usada para fazer mapas e medições simples. O limite dessa tecnologia era que precisava de filme, o que era caro e lento, e também de computadores. Só que, no século XIX e em boa parte do século XX, computadores eram pessoas que eram pagas para fazer contas.

É isso mesmo. Existiam empresas que eram calculadoras. As pessoas eram pagas para encontrar soluções numéricas para equações, fazer gráficos, calcular funções, planilhas, etc. Tudo o que você faz hoje em milésimos de segundo no seu celular, tinha gente que era paga pra fazer e levava um bom tempo. Imagina que você preenchia os dados de uma planilha, aí levava para um empresa de computação para calcular, por exemplo, a soma de uma determinada coluna. Aí três dias depois você passava lá pegar a folha com o resultado!

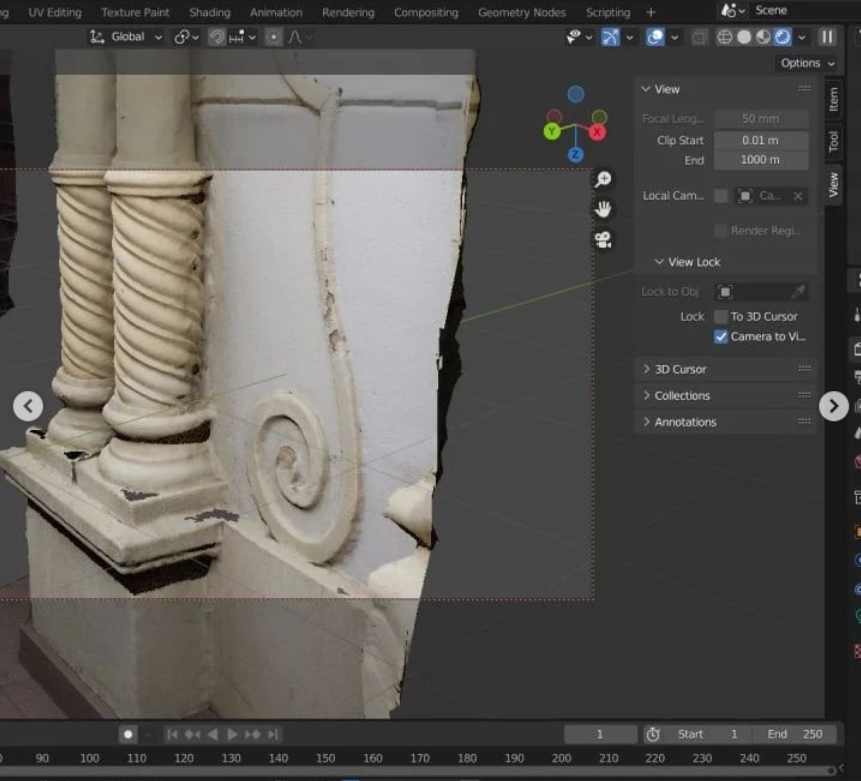

O primeiro problema foi solucionado com a popularização dos sensores tipo CCD e CMOS, que permitem fazer imagens digitais rápidas, precisas e de baixo custo. Tirar 500 fotos, depois da invenção das câmeras digitais, se tornou algo banal. O segundo problema começou a ser resolvido com o surgimento da indústria informática, principalmente depois da popularização dos microchips na década de 70 e da introdução dos computadores pessoais, especialmente da série x86 da Intel. O sucesso da implementação da arquitetura ARM – que levou uns 30 anos, possibilitou o surgimento dos celulares e dispositivos móveis, lá pelos anos 2000 e 2010, aí a coisa decolou de vez. Veja abaixo um modelo que foi digitalizado usando a técnica.

Fotogrametria hoje

Pra quem não conhece a técnica, segue o processo. A ideia é coletar um grade número de fotos dos mais variados ângulos de um objeto, de modo que haja sempre uma sobreposição entre as fotos adjacentes. Através de métodos computacionais, que são operações matemáticas relativamente simples, as fotos são varridas em busca de pontos de interesse. A cada ponto de interesse, um vetor com informação únicas desse é gerado, de modo que, se ele for encontrado em outra foto, possa ser identificado. Cada vetor desse é uma descrição (ou descriptor, do inglês) de cada ponto.

Depois que todas as fotos são varridas e uma boa coleção de pontos de interesse é descrita, as descrições de todo os pontos de todas as fotos são comparadas, de modo a encontrar quais pontos de interesse estão presentes em mais de uma foto. Assim, o computador é capaz de saber qual foto tem o quê, e é por isso que elas precisam ter alguma sobreposição, para garantir que a mesma informação esteja presente em mais de uma foto. Com isso, o algoritmo já consegue organizar as fotos aproximadamente num espaço 3D.

Em seguida, utilizando algoritmos mais avançados, ele vai combinando as fotos, de duas em duas, de modo a encontrar as posições da câmera na cena. Com isso, ele monta a estrutura toda da cena no ambiente virtual, incluindo todas as posições da câmera. Nesse ponto é que é criada a chama nuvem de pontos, que é um termo bem comum na topografia, por exemplo.

A nuvem de pontos, então, é conectada de modo a formar uma rede, que cria os objetos virtuais tridimensionais de fato. Até esse passo, uma laranja digitalizada era só uma coleção de pontos. Depois de feita a rede, ela passa a ser uma laranja 3D. Essa operação, normalmente, é chamada de meshing.

Por fim, o objeto real não é somente um monte de pontos, mas possui cores e texturas. Então as imagens das fotos iniciais são projetadas sobre a superfície 3D, criando as texturas. Em inglês, o termo usado é texturing, que seria algo como texturizar mesmo. Só aí já dá pra ter uma boa ideia do processo. O que o software está fazendo é criar um mapa das imagens originais sobre o objeto virtual para criar uma representação mais realista.

Pra que serve isso?

Muito legal, mas o que fazer com isso? O modelo 3D pode ter muitas aplicações. Ele permite extrair medições tridimensionais a longa distância, por exemplo. Uma aplicação que tem sido desenvolvida nos últimos anos é o emprego de fotogrametria para o monitoramento de pontes. Posicionando diversas câmeras sobre pontos conhecidos, é possível acompanhar a deformação da estrutura, quantitativamente, em tempo real e com precisão de milimetros, mesmo estando a dezenas – ou a centenas, de metros da estrutura. Abaixo está um exemplo de um modelo de uma barragem produzido a partir de 4600 imagens feitas com drones por um grupo de pesquisadores italianos.

Outra aplicação que tem se popularizado é o scanner 3D. Já existem muitos produtos no mercado que fazem exatamente isso. Há aplicativos para celular que são capazes de gerar modelos 3D utilizando a câmera e, mais recentemente, o iPhone 13 Pro passou a incorporar o LiDAR, que é um tipo de radar que utiliza um laser para fazer fotogrametria. Esse sistema é tão bom que já é até usado para fazer levantamentos topográficos.

Uma outra aplicação muito comum é a produção de mapas ortográficos. Uma foto aérea, por exemplo, ainda contém perspectiva. É possível ver a lateral dos objetos nas fotos. O problema é que o mapa aéreo precisa necessariamente ser 2D, porque ele tem que ser capaz de gerar medições precisas. Para e obter uma mapa totalmente 2D, é preciso obter, antes um 3D. A informação da terceira dimensão é subtraída das imagens e o mapa puramente 2D é gerado em seguida. Ou seja, a produção de mapas ortográficos passa por gerar uma representação através da fotogrametria, e o mapa em si é gerado pela texturização das imagens iniciais sobre a maquete virtual.

Fotografia

Mas o assunto aqui era a fotografia, e não outras aplicações. Eu escrevi tudo isso só pra poder chegar no ponto de dizer o que eu acho que deve acontecer. Estamos num ponto da história da tecnologia que os sensores já estão muito bem desenvolvidos e os processadores estão numa subida de poder ainda bem acentuada, especialmente no que diz respeito aos dispositivos móveis. Além disso, tem se tornado uma tendência o surgimento de tecnologias disruptivas, ou seja, inventarem jeitos novos de fazer as coisas de tal modo que as convencionais se tornem totalmente obsoletas. É o caso da Tesla e da Space X, por exemplo. A Apple, por outro lado, também tem se tornado notável nesse sentido, principalmente depois dessa tecnologia de LiDAR no iPhone e dos processadores M1.

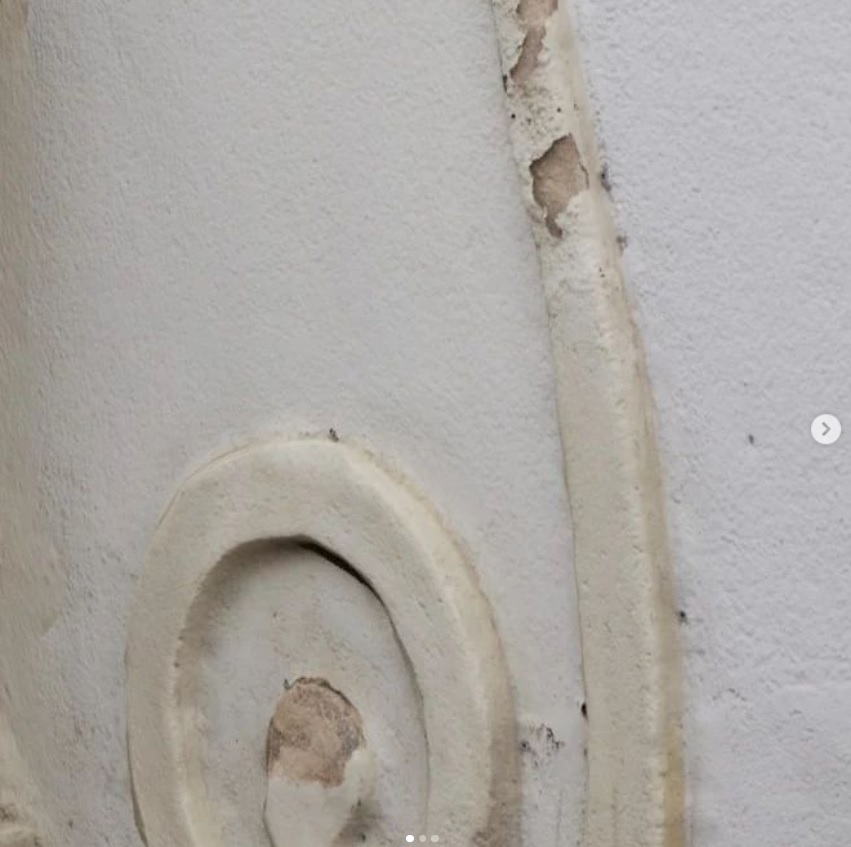

O que eu imagino que as câmeras de um futuro próximo sejam capazes de fazer é capturar a cena toda em 3D utilizando fotogrametria. O usuário, em seguida, vai poder manipular essa cena como quiser, inclusive mudando a iluminação. Essa tecnologia, obviamente, já existe, e se chama renderização. Por exemplo, a imagem abaixo eu gerei exatamente assim. Tirei umas 100 fotos, montei a maquete 3D e depois renderizei a foto usando um software chamado Blender. A questão é que, hoje, ainda é preciso um computador, leva um certo tempo e tem uma boa complicação para fazer. Ainda não é um processo que seja fácil para um leigo, Ainda.

O que eu imagino é que, dentro de pouquíssimo tempo, os celulares já ofereçam essa opção nativamente. Na verdade, não me espantaria nem um pouco se alguém aparecesse aqui dizendo que tem um app que já faz isso. A liberdade criativa com esse processo é muito maior do que com os métodos tradicionais de fotografia, já que o mundo pode ser manipulado virtualmente. Eu acho que isso é o que o futuro reserva aos fotógrafos.

Photoshop 3D

Algumas outras coisas que a fotografia 3D facilitará é que operações que ainda são bem difíceis em 2D, como a remoção de fundo, é relativamente trivial em três dimensões porque o fundo e a frente da foto podem ser facilmente distinguidas na maquete virtual. Também será possível trocar objetos de ambiente sem problemas de continuidade de iluminação.

A manipulação da profundidade de campo na pós-produção também passa a ser trivial, já que todos os objetos estão descritos de acordo com as suas distâncias. Em outras palavras, é possível gerar imagens com o fundo desfocado como se queira, de maneira bem realista, empregando essas técnicas. É como escolher a abertura da lente depois que a foto for tirada. E isso é só alguns exemplos que estou colocando aqui meio no improviso, mas já dá pra ter uma boa ideia do que esperar do futuro não muito distante.

Como o ambiente 3D é a superposição de muitas fotos, a resolução também poderá ser ampliada. Filtros de nitidez poderão ser aplicadas a objetos específicos, assim como técnicas de HDR. Em outras palavras, as técnicas 3D tenderão a tornar obsoletos, inclusive, os sensores full frame, porque a combinação estatística de muitas imagens serão capazes de criar resultados melhores do que o de uma única foto tirada com um sensor maior.

Do ponto de vista da fotografia como ferramenta técnica, em engenharia e topografia, por exemplo, essas coisas abrem possibilidades extremamente interessantes. Por exemplo, será possível fazer inspeções quantitativas de estruturas em tempo real com o celular. Inclusive, uma das tendências atuais é o reconhecimento de imagens por inteligência artificial, que é assunto pra um outro artigo. Com essa tecnologia e com o modelo 3D, é possível que o próprio aplicativo encontre e quantifique trincas em colunas de concreto, por exemplo, e essa é uma tecnologia que eu mesmo venho estudando. As aplicações dessas técnicas empregando drones, por exemplo, são praticamente ilimitadas.

Enfim, acho que já deu pra ilustrar o ponto desse artigo. O futuro próximo da fotografia parece ser mesmo o ambiente 3D e a renderização. Vamos ver, em pouco tempo, se acertei ou não.